当你搜索 OpenRouter 替代方案 时,你真正想要的往往不是"换个路由"。

而是这个:

OpenRouter 用起来确实方便,但随着用量增长,成本开始让人肉疼——你想找一个能真正改善单位经济效益的替代品,同时又不想把迁移搞成一次大重构。

本文将对比五个团队常用的选项:

- LiteLLM(自托管 LLM 网关)

- Replicate(按算力计费的模型执行平台)

- fal.ai(生成式媒体平台)

- WaveSpeedAI(视觉生成工作流)

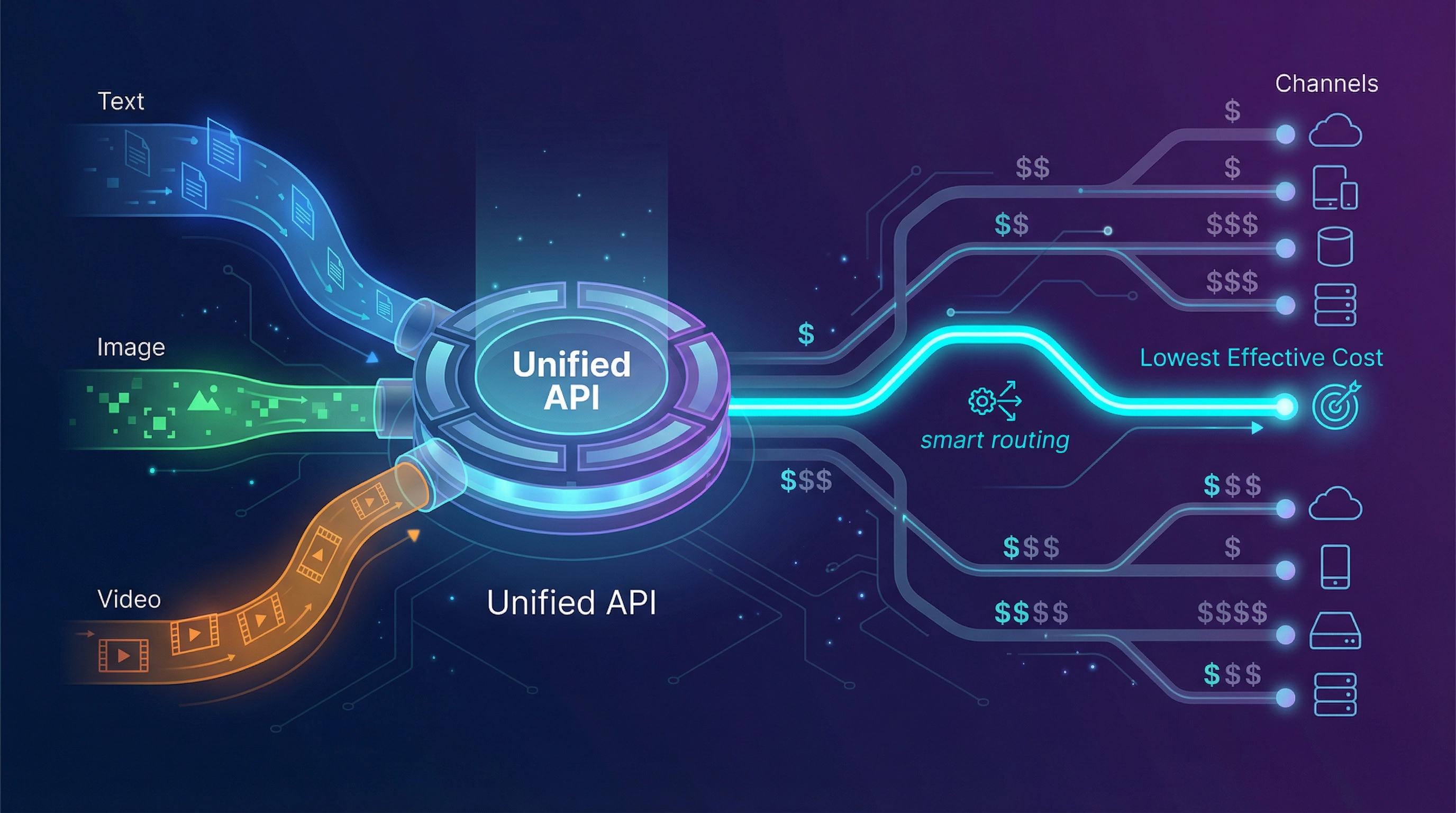

- EvoLink.ai(支持智能路由的 chat/image/video 统一网关)

我们也会以 OpenRouter 作为基准进行对比。

太长不看:先评估哪个?

- 需要 自托管 + 完全掌控 → LiteLLM

- 工作负载是 计算任务型,需要透明的硬件定价 → Replicate

- 主要开销在 图片/视频生成 → fal.ai 或 WaveSpeedAI

- 成本问题源于 渠道价差,希望用一个 API 统一 chat + image + video → EvoLink.ai

想快速试试 EvoLink?

→ 免费开始 → 获取 EvoLink API Key

"OpenRouter 太贵了"在生产环境中到底意味着什么

大多数团队在早期原型阶段不会感受到成本压力。成本真正变得刺眼,通常是在:

- 有了真实用户(用量不可预测)

- 开始出现重试(429 错误/超时爆发)

- 引入多模态功能(文本 + 图片 + 视频)

- 开始优化毛利率和单位经济效益

这时候,你不再只关心"token 单价",而是开始关心每次结果的实际成本:

- 每次成功客服解决的成本

- 每次 Agent 工作流完成的成本

- 每张图片资产的成本(含重试和失败)

- 每个短视频的成本(含失败和队列浪费)

15 分钟切换前检查清单

| 步骤 | 操作 | 产出 |

|---|---|---|

| 1 | 选定一个 KPI:每次结果的实际成本 | 全团队可以对齐的单一指标 |

| 2 | 测量重试率、错误率、p95 延迟 | "浪费"和用户体验影响的基线 |

| 3 | 明确工作负载类型:纯文本 vs 多模态 | 决定是否只需要"LLM 路由" |

| 4 | 决定容忍度:托管服务 vs 自托管 | 决定选 LiteLLM 还是托管工具 |

| 5 | 规划上线:影子流量 → 灰度 → 全量 | 避免高风险的一刀切迁移 |

"实际成本堆栈"(钱都花哪儿了)

| 层级 | 成本驱动因素 | 表现形式 | 该测什么 |

|---|---|---|---|

| L1 | 使用成本 | token / 按产出 / 按秒 | 每次会话/任务/资产的 $ |

| L2 | 渠道价差 | 同样能力,不同渠道实际价格不同 | 各路由的价格分布 |

| L3 | 失败浪费 | 重试、超时、429 风暴 | 重试率、每 1k 调用的错误数 |

| L4 | 工程开销 | 多个 SDK、多个账单账户、版本漂移 | 每次集成花费的时间 |

| L5 | 模态蔓延 | 文本 + 图片 + 视频分散在多个平台 | 关键路径中的供应商数量 |

如果觉得 OpenRouter 贵,问题往往出在 L2–L5。

表 1 — 平台适配矩阵(对应"OpenRouter 太贵"的场景)

| 平台 | 何时是 OpenRouter 的强力替代 | 典型计费模式 | 迁移摩擦 | 需权衡的点 |

|---|---|---|---|---|

| LiteLLM | 想要自托管控制(预算、路由、治理)且能运维基础设施 | 开源网关/代理 + 自有基础设施成本 | 中高 | 你要负责运维:高可用、升级、供应商 API 变更、监控管道 |

| Replicate | 工作负载是计算任务型,想要公开的硬件定价 | 按算力时间/硬件秒计费(因模型而异) | 中 | 运行时间波动会导致成本波动;需用真实输入测试 |

| fal.ai | 媒体密集型(图片/视频/音频),想要丰富的模型库 + 规模化能力 | 按用量的生成式媒体平台 | 中 | 实际成本高度依赖所选模型 + 工作流设计 |

| WaveSpeedAI | 构建视觉生成工作流(图片/视频),媒体优先 | 按用量的媒体平台 | 中 | 通常是 LLM 路由的补充,而非替代 |

| EvoLink.ai | 想通过跨渠道智能路由降低实际成本,并统一 chat + image + video | 按用量的网关;路由驱动的成本优化 | 中低 | 如需严格自托管/本地部署或特定合规要求,需确认适配性 |

| OpenRouter(基准) | 用一个 API 快速切换 LLM 模型 | Token 式 LLM 访问 | N/A | 当实际成本上升(浪费 + 开销 + 蔓延)时会感觉贵 |

工作负载原型:选一个匹配你产品的替代方案

| 工作负载类型 | 优化目标 | 最佳选项 | 原因 |

|---|---|---|---|

| SaaS 聊天 / 客服助手 | 每次会话成本、p95 延迟、重试浪费 | LiteLLM、EvoLink | LiteLLM 用于自托管治理;EvoLink 用于路由经济性 + 统一技术栈 |

| 编程 Agent / 开发工具 | 突发处理、组织预算/密钥、模型灵活性 | LiteLLM、EvoLink | LiteLLM 用于平台控制;EvoLink 用于低摩擦 + 成本感知路由 |

| 营销图片(大批量变体) | 每张资产成本、吞吐量、异步/webhook | fal.ai、WaveSpeedAI、EvoLink | fal/WaveSpeed 媒体优先;EvoLink 适合跨模态统一入口 |

| 短视频生成 | 每个视频成本、队列行为、失败浪费 | fal.ai、WaveSpeedAI、EvoLink | 媒体平台专业化;EvoLink 适合统一多模态 + 路由经济性 |

| 研究/实验 | 覆盖度、快速原型、基础设施定价透明 | Replicate、OpenRouter | Replicate 适合计算型;OpenRouter 便于 LLM 迭代 |

替代方案详解:如何评估

1) LiteLLM — 自托管网关控制(OpenAI 格式)

团队评估 LiteLLM 通常是因为:

- 想要跨供应商的 OpenAI 格式接口

- 需要集中式预算、限速和治理

- 需要自托管/本地部署选项

LiteLLM 的优势场景

- 你想在自己环境内掌控策略层(预算、认证、路由规则)

- 你愿意用工程时间和运维责任换取供应商独立性

容易踩的坑

- "路由"变成了你的责任:

- 高可用、扩容、故障响应

- 供应商 API 变更

- 日志/指标管道

- 必须主动管理重试/降级才能避免浪费

如何低风险测试 LiteLLM

- 从测试环境开始

- 使用影子流量(复制请求;不影响用户)

- 尽早设置消费限额

- 输出一致性验证通过后再升级到灰度

2) Replicate — 按算力计费的模型执行平台

Replicate 适合的场景是你的工作负载更像"任务"而非对话轮次:

- 你把模型预测当作计算任务来跑

- 你想要透明的硬件定价层级(GPU $/秒)

Replicate 的优势场景

- 非常适合实验和计算型工作负载

- 硬件定价透明,便于预测(运行时间稳定时)

容易踩的坑

- 运行时间波动 = 成本波动

- 不同模型和工作负载的生产级可靠性可能不同

如何测试 Replicate

- 用真实输入做基准测试

- 记录运行时间分布(p50/p95/p99)

- 转换为每次结果成本(资产/任务),而非仅看每秒成本

3) fal.ai — 生成式媒体平台(丰富模型库 + 规模化)

fal.ai 通常被媒体密集型产品选择:

- 图片/视频/音频生成

- 丰富的模型库

- 性能和规模化定位

fal.ai 的优势场景

- 你想在一个平台上获得广泛的媒体生成能力

- 你看重媒体 API 的速度/规模故事

容易踩的坑

- 实际成本极度依赖模型选择和工作流设计

- 异步/webhook 设计选择会显著影响失败浪费

如何测试 fal.ai

- 挑选 2–3 个匹配你产品的端点/模型

- 测试:

- 单次运行延迟

- 批量吞吐

- 跟踪:失败浪费和每张资产成本

4) WaveSpeedAI — 媒体优先的视觉工作流

WaveSpeedAI 常被评估用于图片/视频生成工作流。

WaveSpeedAI 的优势场景

- 你想要一个媒体优先的视觉生成平台

- 你的产品更偏向"生成资产"而非"对话助手"

容易踩的坑

- 可能是 LLM 路由的补充,而非替代

- "更便宜"取决于工作流结构(异步任务、重试等)

如何测试 WaveSpeedAI

- 测量每张资产成本

- 测量结果时间分布

- 验证批量负载下的稳定性

5) EvoLink.ai — 通过路由经济性 + 统一多模态 API 降低实际成本

如果你的抱怨是"OpenRouter 太贵了",关键问题是:贵在哪里?

如果答案是:

- 你的实际成本被渠道价差推高

- 重试和失败造成浪费

- 你的应用正在变成多模态(文本 + 图片 + 视频)

- 你不想管理五个不同的供应商集成

……那么 EvoLink 正是为这种情况设计的。

EvoLink 的公开定位:

- 一个 API 搞定 chat、image 和 video

- 40+ 模型

- 智能路由,旨在降低成本(宣称"最高节省 70%")

- 可靠性承诺包括 99.9% 可用性和自动故障转移

如何评估 EvoLink(让财务和工程都信服)

- 选 1 个有代表性的工作流(不是玩具 prompt)

- 跑 24–48 小时的 1–5% 灰度

- 对比每次结果实际成本、重试率、p95 延迟

- 保持回滚能力

从这里开始

- 主入口:免费开始 → 获取 API Key

- 模型目录:EvoLink Models

- 接入文档:EvoLink API Docs

- 工程实践:GPT Image 1.5 生产指南

如何决策(别想太多):简单决策流

-

需要自托管/本地部署/深度内部治理? → 从 LiteLLM 开始。

-

工作负载主要是媒体生成(图片/视频)? → 从 fal.ai 或 WaveSpeedAI 开始。

-

工作负载是计算任务型,关心运行时经济性? → 从 Replicate 开始。

-

想要 chat/image/video 统一入口,成本问题是实际成本(渠道价差 + 浪费)? → 测试 EvoLink:免费开始

表 2 — 实际成本优化清单(无论选哪个平台都适用)

| 问题 | 症状 | 解决方案 |

|---|---|---|

| 重试风暴 | 供应商抖动时费用飙升 | 重试上限 + 排队 + 退避 |

| 用户操作导致重复计费 | 重复点击 = 重复调用 | 幂等键 + UI 节流 |

| 高价路径使用过多 | 所有流量走高端选项 | 路由策略 + 预算 |

| 日志变成成本中心 | 永久存储所有内容 | 采样 + 保留期限 |

| 费用难以分摊 | "AI 成本"是一个大桶 | 按功能/团队/用户打标签 |

迁移手册:切换时别把"更便宜"变成"更危险"

表 3 — 低风险上线计划(可直接复制)

| 阶段 | 做什么 | 完成标志 |

|---|---|---|

| 基线 | 测量每次结果实际成本、重试率、p95 延迟 | 能解释清楚成本驱动因素 |

| 影子 | 复制请求到新平台(不影响用户) | 输出可比;无破坏性故障 |

| 灰度 | 路由 1–5% 真实流量 | KPI 改善或持平;回滚可用 |

| 扩量 | 10% → 25% → 50% → 100% | 峰值负载下稳定 |

| 优化 | 调优路由 + 预算 | 随量增长成本曲线改善 |

避免"工具便宜,结果昂贵"的防护机制

- 用户操作幂等

- 重试上限 + 排队

- 按密钥/团队/项目设预算上限

- 基于失败类型的降级规则(超时/429/5xx)

- 日志采样(别永久存所有东西)

彩蛋:可以交给团队的实际成本工作表

| 指标 | 基线(OpenRouter) | 候选 A | 候选 B |

|---|---|---|---|

| 每次结果实际成本 | |||

| 重试率 (%) | |||

| 错误率 (每 1k) | |||

| p95 延迟 (ms) | |||

| 关键路径中的供应商数 (#) | |||

| 迁移工作量 (人天) |

总结推荐(基于"OpenRouter 太贵"的场景)

- 需要 自托管治理 + 完全掌控 → LiteLLM

- 工作负载是 计算任务型,需要透明硬件定价 → Replicate

- 主要是 图片/视频生成 → fal.ai 或 WaveSpeedAI

- 想通过 路由经济性降低实际成本,并统一 chat/image/video → EvoLink.ai 试试看:免费开始 → 获取 EvoLink API Key

下一步(实用导向)

- 根据工作负载类型选第一个候选

- 跑 24–48 小时的 1–5% 灰度

- 对比:每次结果实际成本 + 重试率 + p95 延迟

- 回滚验证通过后再扩量

- 如果测试 EvoLink:

声明(避免事实错误)

- 定价、模型目录和功能集经常变化。做预算决策前请到各供应商官网确认最新信息。

- 本文引用 OpenRouter 是为了搜索意图对齐,与 OpenRouter 没有关联关系。