路由器不会让一台服务器不堪重负,而是智能地将传入的请求分配到服务器池中,或者在现代 AI 应用程序的背景下,分配到不同的 AI 模型中。结果是一个高度可用、高性能的应用程序,为您的用户提供无缝体验。

负载均衡路由器如何工作?

从核心上讲,负载均衡路由器旨在消除单点故障。在典型的单服务器架构中,如果该服务器过载或离线,您的整个应用程序就会陷入停顿。

负载均衡路由器位于您的用户和服务器池之间,拦截每个传入的请求,并决定哪个下游资源在那一刻最有能力处理它。这个概念已经从早期的硬件设备显着演变为支撑现代分布式系统的复杂软件层。理解这一原理是构建弹性系统的第一步,尤其是在处理 API 流量的不可预测性时。

为什么每个现代应用程序都需要一个

对于开发者来说,实施良好的负载均衡器提供了关键优势:

- 高可用性: 如果服务器或 API 端点发生故障或无响应,路由器会自动将其从池中移除并将流量重定向到健康的实例。您的应用程序保持在线。

- 可扩展性: 为了处理增加的负载,您只需向池中添加更多服务器。负载均衡器将立即开始向它们路由流量,实现无停机时间的水平扩展。

- 提高性能: 通过分配工作负载,您确保用户请求始终由响应迅速的服务器处理,从而减少延迟并改善整体用户体验。

将负载均衡路由器视为您的应用程序抵御中断的第一道防线。它将一组独立的服务器转变为一个单一、强大且弹性的系统。

掌握这个概念可以让您从一开始就为弹性进行架构设计,而不是将其作为事后的想法。

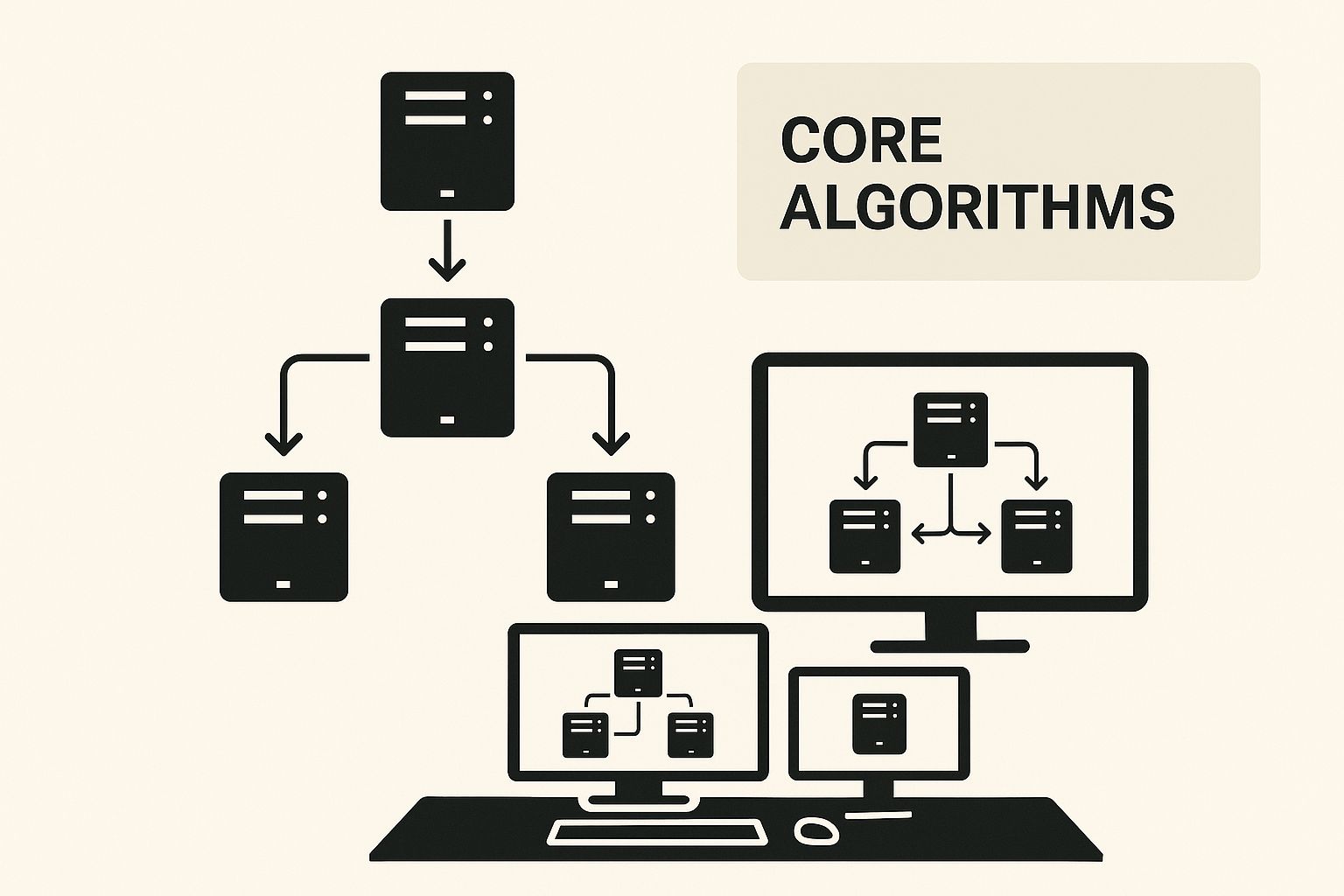

理解核心负载均衡算法

这些算法为分配工作负载提供了逻辑。下图说明了不同的策略如何协同工作以有效管理网络流量。

如您所见,这些基本方法是更复杂的路由决策的基石。目标是防止任何单一服务器不堪重负并导致系统级故障。

常见分配方法

那么,负载均衡器如何决定将流量发送到哪里?它通常使用几种标准算法之一。

-

轮询 (Round Robin):这是最简单和最常用的方法。负载均衡器循环遍历服务器列表,将每个新请求发送到序列中的下一个服务器。它是可预测的,但假设所有服务器具有相同的容量,并且所有请求具有相似的处理成本。

-

最少连接 (Least Connections):这是一种更动态的策略。该算法将新请求路由到具有最少活动连接的服务器。这在连接持续时间变化的环中特别有效,可以防止一台服务器被长时间运行的任务占用,而其他服务器处于空闲状态。

-

IP 哈希 (IP Hash):此方法使用客户端 IP 地址的哈希值将该客户端一致地映射到同一台服务器。主要好处是会话持久性(或“粘性”),这对于像电子商务购物车这样的有状态应用程序至关重要,因为用户会话数据必须维护在特定的服务器上。

比较常见的负载均衡算法

选择正确的算法取决于您的应用程序的具体要求。此表分解了最常见的方法,以帮助您进行比较。

| 算法 | 如何工作 | 最适合 | 潜在缺点 |

|---|---|---|---|

| 轮询 | 按顺序将请求分发到列表中的每个服务器。 | 服务器相同且请求均匀的环境。 | 不考虑服务器负载或不同的处理时间。 |

| 最少连接 | 将新请求发送到活动连接最少的服务器。 | 连接寿命长或请求负载不均的情况。 | 跟踪连接可能更耗费计算资源。 |

| IP 哈希 | 根据源 IP 地址将请求分配给特定服务器。 | 需要会话持久性的应用程序(例如,购物车)。 | 如果某些 IP 地址发送大量请求,可能导致分布不均。 |

| 加权轮询 | 轮询的变体,其中根据容量为服务器分配“权重”。 | 具有不同处理能力的服务器的环境。 | 需要手动配置权重并随时间调整。 |

最终,没有单一的“最佳”算法。目标是将分发逻辑与您的应用程序行为和基础设施架构保持一致。

加权和智能路由

虽然这些经典算法对于传统的网络流量有效,但在跨多个提供商路由 AI 请求时,它们就显得力不从心了。简单的轮询算法没有成本或可用性的概念;它可能会盲目地将您的请求发送给昂贵或不可用的提供商。这正是像 EvoLink 这样的高级负载均衡路由器解决的问题,它会实时地将您选择的模型智能路由到最具成本效益和可靠的提供商。

AI 模型路由的现代挑战

传统的负载均衡假设您在一组相同的服务器之间分配流量。这种模型对于无状态的 Web 请求非常有效,但在应用于多样化的 AI 模型生态系统时完全崩溃。

像 GPT-4、Llama 3 和 Claude Haiku 这样的模型是不可互换的。它们在推理能力、响应延迟以及至关重要的每 token 成本方面存在显著差异。这使得问题从简单的流量分配转变为复杂的多目标优化难题。

在这里使用基本的轮询方法是低效且昂贵的。您可能会将简单的摘要任务路由到最强大(且最昂贵)的模型,而复杂的分析查询可能会被发送到更快但能力较弱的模型,从而导致次优的响应。

从统一服务器到多个 AI 提供商

一旦您选择了所需的 AI 模型,原生 AI 路由器必须为每个请求评估几个因素:

- 提供商成本: 相同的 GPT-4 模型在一个提供商处的价格可能比另一个提供商高 10 倍。为您选择的模型找到最便宜的可用提供商可立即节省开支。

- 提供商可用性: 提供商当前是否在线且响应迅速?实时健康检查确保您的请求始终到达工作的端点。

- 提供商延迟: 哪个提供商目前提供最快的响应时间?动态性能监控路由到该时刻响应最快的提供商。

智能 AI 路由器不仅仅是平衡负载;它针对业务成果进行优化。对于您选择的模型,它会为每个 API 调用做出动态、明智的决定,通过选择最佳提供商,以尽可能低的成本提供最佳性能。

智能提供商路由的代码示例

这个概念性的 JavaScript 函数演示了为所选模型选择最佳提供商的逻辑。它检查提供商的可用性和成本以路由到最佳端点。

// 一个为所选模型选择最佳提供商的概念函数

async function routeToProvider(selectedModel) {

// 用户已选择 GPT-4 作为他们的模型

const providers = [

{ name: 'OpenAI', endpoint: 'https://api.openai.com/v1/chat/completions', cost: 0.03, available: true },

{ name: 'Azure', endpoint: 'https://azure.openai.com/v1/chat/completions', cost: 0.035, available: true },

{ name: 'Provider-A', endpoint: 'https://api.provider-a.com/v1/gpt-4', cost: 0.015, available: true },

{ name: 'Provider-B', endpoint: 'https://api.provider-b.com/v1/gpt-4', cost: 0.012, available: false }

];

// 过滤掉不可用的提供商

const availableProviders = providers.filter(p => p.available);

// 按成本排序,最便宜的优先

availableProviders.sort((a, b) => a.cost - b.cost);

// 选择最便宜的可用提供商

const selectedProvider = availableProviders[0];

console.log(`Routing ${selectedModel} to ${selectedProvider.name} at $${selectedProvider.cost} per request`);

// 在实际应用程序中,您会在这里进行 API 调用

// const response = await fetch(selectedProvider.endpoint, { ... });

// return response.json();

return {

model: selectedModel,

provider: selectedProvider.name,

endpoint: selectedProvider.endpoint,

cost: selectedProvider.cost

};

}

// 示例用法 - 用户选择了 GPT-4

routeToProvider('GPT-4').then(result => console.log(result));虽然这段代码说明了核心概念,但构建一个生产级系统涉及更多内容:管理数十个提供商的 API 密钥,跟踪实时定价和可用性,在提供商宕机时实施自动故障转移,以及持续监控性能。

用 EvoLink 将高级 AI 路由付诸实践

从头开始构建智能 AI 路由器是一项重大的工程挑战。它需要管理多个 API 密钥,监控实时模型性能,编写强大的故障转移逻辑,并在发布新模型时不断更新系统。这就是为什么像 EvoLink 这样的托管解决方案对开发团队来说是一个游戏规则改变者。

这种统一的方法大大减少了运营开销,并使您的工程团队能够专注于您的核心产品,而不是管理 AI 基础设施。

智能路由在现实世界中如何工作

以下是 EvoLink 的核心功能如何带来实实在在的好处:

- 自动模型故障转移: 如果像 OpenAI 这样的主要提供商遇到中断或性能下降,EvoLink 会自动将 API 调用重新路由到提供相同模型的健康替代提供商。您的应用程序将继续无缝运行。

- 动态性能路由: 系统持续监控您选择的模型的所有可用提供商的延迟和吞吐量,将每个请求发送到那一刻能够提供最快响应的提供商。

- 智能成本优化: EvoLink 自动将您的请求路由到您选择的模型的最具成本效益的提供商,不断比较数十个提供商的价格,以确保您始终获得最佳费率。

通过智能地引导流量,使用 EvoLink 的开发者通常可以实现 20-70% 的成本节省。这不仅仅是选择最便宜的提供商;它是关于为每个请求做出最明智的提供商选择,以便在使用您首选的模型时平衡性能和预算。

EvoLink 的实用代码示例

考虑这个 Python 示例。您提供一个优先模型列表,EvoLink 会自动管理所有路由、优化和故障转移。

import os

import requests

# 从环境变量设置您的 EvoLink API 密钥

api_key = os.getenv("EVOLINK_API_KEY")

api_url = "https://api.evolink.ai/v1/chat/completions"

headers = {

"Authorization": f"Bearer {api_key}",

"Content-Type": "application/json"

}

# 定义您的首选模型和回退选项

# EvoLink 将每个模型路由到最便宜的可用提供商

# 如果您的第一选择不可用,它将故障转移到列表中的下一个模型

payload = {

"model": ["openai/gpt-4o", "anthropic/claude-3.5-sonnet", "google/gemini-1.5-pro"],

"messages": [

{"role": "user", "content": "Analyze the sentiment of this customer review: 'The product is good, but the shipping was slow.'"}

]

}

try:

response = requests.post(api_url, headers=headers, json=payload)

response.raise_for_status() # 为错误响应(4xx 或 5xx)引发 HTTPError

print(response.json())

except requests.exceptions.RequestException as e:

print(f"An API error occurred: {e}")此片段演示了抽象的力量。您的应用程序代码保持干净并专注于业务逻辑,而强大的负载均衡路由器在后台工作,使您的应用程序更具弹性和成本效益。

EvoLink 消除 了构建和维护复杂的内部系统的需求,提供了一个可立即投入生产的解决方案,并带来立竿见影的效果。这使您的团队能够更快、更高效地集成世界级的 AI 能力。

您可以实施的实用路由策略

让我们探索您可以实施的四种实用策略。

基于成本的路由

此策略优先考虑您的预算。基于成本的路由会自动将您的请求发送给您选择的模型的最实惠的提供商。

基于延迟的路由

当用户体验至关重要时,基于延迟的路由是最佳选择。这对于实时应用程序(如客户服务聊天机器人或交互式 AI 工具)至关重要,因为每一毫秒都很重要。

路由器持续监控您选择的模型的所有可用提供商的实时性能。当请求到达时,它会立即转发到当前响应时间最低的提供商,确保您的用户收到尽可能快的回复,而无需更改您正在使用的模型。

故障转移路由

故障转移路由是您应用程序的安全网。API 提供商不可避免地会遇到中断或性能下降。发生这种情况时,路由器会自动将请求重新路由到预定义优先级列表中的下一个健康模型。

此策略是构建高可用性系统的基础,这些系统可以优雅地处理提供商故障,而不会对最终用户体验产生任何影响。

常见问题

负载均衡器和路由器有什么区别?

虽然经常一起使用,但这些组件在网络中具有不同的功能。

我可以自己构建 AI 模型负载均衡器吗?

从技术上讲,是的,您可以构建自定义解决方案。然而,生产级 AI 路由器的复杂性是巨大的。

一个强大的解决方案不仅仅需要基本的请求分发。您将负责安全地管理数十个 API 密钥,跟踪每个模型的实时成本和延迟,实施可靠的健康检查,并设计有效的故障转移逻辑。此外,该系统还需要不断的维护,以整合新模型并适应 API 变化。

这正是像 EvoLink 这样的托管解决方案提供巨大价值的地方。我们已经设计了一个经过生产强化的系统来处理所有这些复杂性。您获得了一个内置智能路由的单一统一 API,使您的团队能够专注于您的核心产品而不是基础设施。这种方法可以立即节省 20-70% 的成本,并从第一天起确保高可靠性。

负载均衡路由器实际上如何使我的应用程序更可靠?

可靠性通过两个主要机制实现:冗余和自动健康检查。

通过在多个模型或服务器之间分发请求,负载均衡器消除了单点故障。如果一个模型 API 不可用或服务器崩溃,应用程序仍可保持运行,因为流量会自动定向到健康的替代方案。

系统还会对每个端点执行持续的健康检查,就像监测生命体征一样。它定期发送请求以验证每个端点是否响应。如果端点未能通过这些检查或返回错误,路由器会立即将其从活动池中移除,并将新请求无缝重定向到剩余的健康端点。这种自动故障转移确保了高可用性,即使在部分系统故障期间也是如此。