如果你在搜索 DeepSeek V4,大概率是想弄清楚一个问题:新一代 DeepSeek 旗舰模型真的会在春节前后发布吗?对写代码的场景到底有多大提升?

目前最可靠的报道指向:DeepSeek V4 预计于 2026 年 2 月中旬发布,主打代码能力和超长代码上下文——但 DeepSeek 官方尚未公开确认全部细节。DeepSeek to launch new AI model focused on coding in February, The Information reports | Reuters

哪些是实锤、哪些还是传闻

在"V4 即将发布"的消息满天飞时,最有价值的事情就是把有出处的信号和社区的推测分开。

信息核实速查表

| 话题 | 目前有据可查 | 仍存在不确定性 | 为什么要关注 |

|---|---|---|---|

| 发布时间 | 据 The Information 报道,预计在2 月中旬 | 具体日期、分批上线、各地区可用性 | 影响上线计划和值班安排 Reuters |

| 核心定位 | 强化代码能力 + 支持超长代码提示 | Benchmark 表现、实际工程场景、工具调用行为 | 决定是否值得替换现有代码模型 Reuters |

| 性能声明 | 据称"内部测试显示"在部分指标上领先对手 | 缺乏独立验证、鲁棒性和回归表现未知 | 切换前需要自己跑评测 Reuters |

| 社区热度 | Reddit 上正在热议 V4 时间线和期望 | 很多帖子是二手转述 | 可以了解开发者诉求,但不能当作事实依据 r/LocalLLaMA |

为什么 DeepSeek V4 在 Reddit 上这么火(开发者到底想要什么)

Reddit 上的讨论不只是跟风炒作,背后往往反映了真实的开发痛点:

-

需要仓库级别的上下文,而不是玩具代码片段 Reuters 报道提到 V4 在处理"超长代码提示"方面有突破——这正好对应日常工作:大段 diff、跨文件重构、迁移任务、"帮我读懂这个老模块"等场景。Reuters

-

切换成本才是真正的瓶颈 大多数团队一下午就能跑通新模型的 demo。真正麻烦的是:鉴权、限流、请求/响应格式差异、流式输出差异、工具调用规范、成本核算、容灾降级……这也是为���么"网关/路由"架构在基础设施圈子里越来越流行。

-

"兼容 OpenAI"听起来美好,实际未必 就算两个厂商都号称兼容 OpenAI,上了生产环境往往会在工具调用、结构化输出、错误语义、用量上报等细节上踩坑。这些差异正是团队在"简单迁移"时浪费时间的根源。

如何在 DeepSeek V4 发布前做好准备(实操清单)

不需要等模型上线才开始准备。你需要的是一套方案,让接入新模型变成一次配置变更。

1)在应用前面加一层 LLM 网关/路由

目标: 你的产品只对接一个内部接口;由路由层决定模型和供应商。

最低要求:

- 按请求路由(按任务类型:写单测、重构、对话、日志摘要)

- 容灾降级(供应商宕机、限流、延迟飙升)

- 可观测性(延迟、错误率、token 数、成本)

- Prompt 版本管理(方便快速回滚)

2)准备一套"V4 就绪"评测集(小而精、可复现)

好的预发布评测集不是刷榜 benchmark,而是你们自己的失败案例:

- 一个团队曾经卡了很久的真实 bug

- 一次带测试的跨文件重构

- 一个"读懂这个模块并提出安全改动建议"的任务

- 一个长上下文检索场景(文档 + 代码 + 配置混合)

3)先定义好"更好"的标准(测之前就要想清楚)

选 3–5 个验收指标:

- 补丁能编译 + 测试通过(是/否)

- 首次正确 PR 的耗时

- API 使用相关的幻觉率

- 每解决一个 issue 的 token/成本

- 典型 prompt 大小下的 P95 延迟

轻量级集成模板(OpenAI 风格,模型无关)

下面是一个可以放在网关后面的请求模板。不要把 model 名称当真——等 DeepSeek V4 正式发布后再换成真实名称。

# 伪代码:保持应用稳定,在网关后面切换供应商/模型

payload = {

"model": "deepseek-v4", # 占位符

"messages": [

{"role": "system", "content": "你是一个代码助手,倾向于小改动并补充测试。"},

{"role": "user", "content": "重构这个函数并添加单元测试..."}

],

"temperature": 0.2,

}

resp = llm_client.chat_completions(payload) # 你的内部封装如果你已经为部分模型标准化了 OpenAI 兼容接口,需要注意:虽然 DeepSeek 在常见开发者指南中被描述为 OpenAI 兼容,但兼容性不等于生产环境行为完全一致。DeepWiki

EvoCode 这边会怎么做

一旦 DeepSeek V4 通过可靠的 API 公开可用,EvoCode 会尽早集成——但前提是通过基本验证(可用性、延迟、错误行为,以及代码评测的最低质量门槛)。这样可以避免常见的坑:"首日集成"结果影响真实业务。

发布周监控清单(实时关注哪些信号)

| 监控信号 | 为什么重要 | 发现后立即做什么 |

|---|---|---|

| 官方模型标识 + API 文档 | 避免硬编码假设 | 更新路由配置和接口约定 |

| 各供应商实际开放的上下文长度 | 长上下文能力只有真能用才有意义 | 加上自动 prompt 分片/截断 |

| 限流 / 容量 | 发布周往往会被限流 | 开启降级和队列 |

| 定价和 token 计费字段 | 预算和回归追踪必备 | 与现有基线对比单任务成本 |

常见问题(大家都在问的)

DeepSeek V4 会在春节前后发布吗?

报道指向 2026 年 2 月中旬春节前后,但时间表被描述为仍有变数。Reuters

DeepSeek V4 确定是最强代码模型吗?

不确定。目前公开引用的最强表述是"内部测试";建议等独立验证出来后再下结论,或者自己跑评测。Reuters

为什么 Reddit 上都在讨论?

因为"可靠报道 + 代码场景 + 节假日发布"这套组合拳,正好戳中开发者想尝鲜的心理。r/LocalLLaMA

要不要等 V4 出来再选 LLM 技术栈?

不用等。现在就搭好路由/网关抽象,等 V4 出来后切换成本会很低。

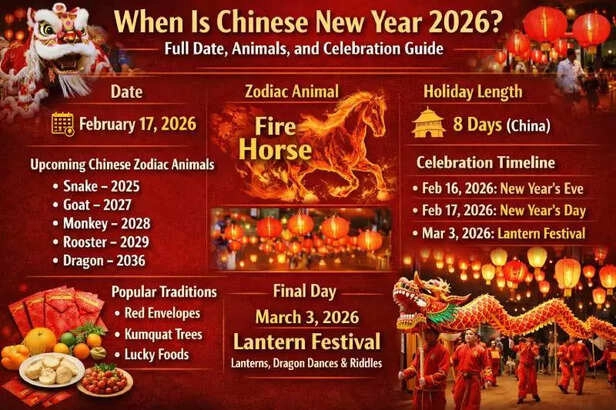

附:春节时间参考(仅供说明)