产品发布

OpenCode 集成指南:如何通过 EvoLink API 访问 Claude 4.5、GPT-5.2 和 Gemini 3 Pro (2026)

Zeiki

CGO

2026年1月15日

14 分钟阅读

介绍:基于终端的 AI 新时代

在 2026 年快速发展的格局中,开发者的终端已从简单的命令行转变为复杂的人工智能指挥中心。在 IDE、基于浏览器的聊天机器人和 API 文档之间切换上下文的日子已经结束。今天,最高效的开发者正在将 AI 代理直接集成到他们的 CLI 工作流中。

然而,出现了一个新的挑战:模型碎片化。您需要 Claude 4.5 凭借其卓越的编码能力,GPT-5.2 用于复杂推理,以及 Gemini 3 Pro 用于其巨大的上下文窗口。管理三个单独的订阅和 API 密钥既低效又昂贵。

本指南提出了终极解决方案:将 OpenCode(领先的开源终端编码代理)与 EvoLink(统一 API 网关)集成。通过遵循这个“摩天大楼”指南,您将学习如何构建一个健壮、具有成本效益的开发环境,让您按需访问世界顶级的 AI 模型——在提高编码速度的同时节省高达 70% 的 API 成本。

第一部分:您的 AI 堆栈组件

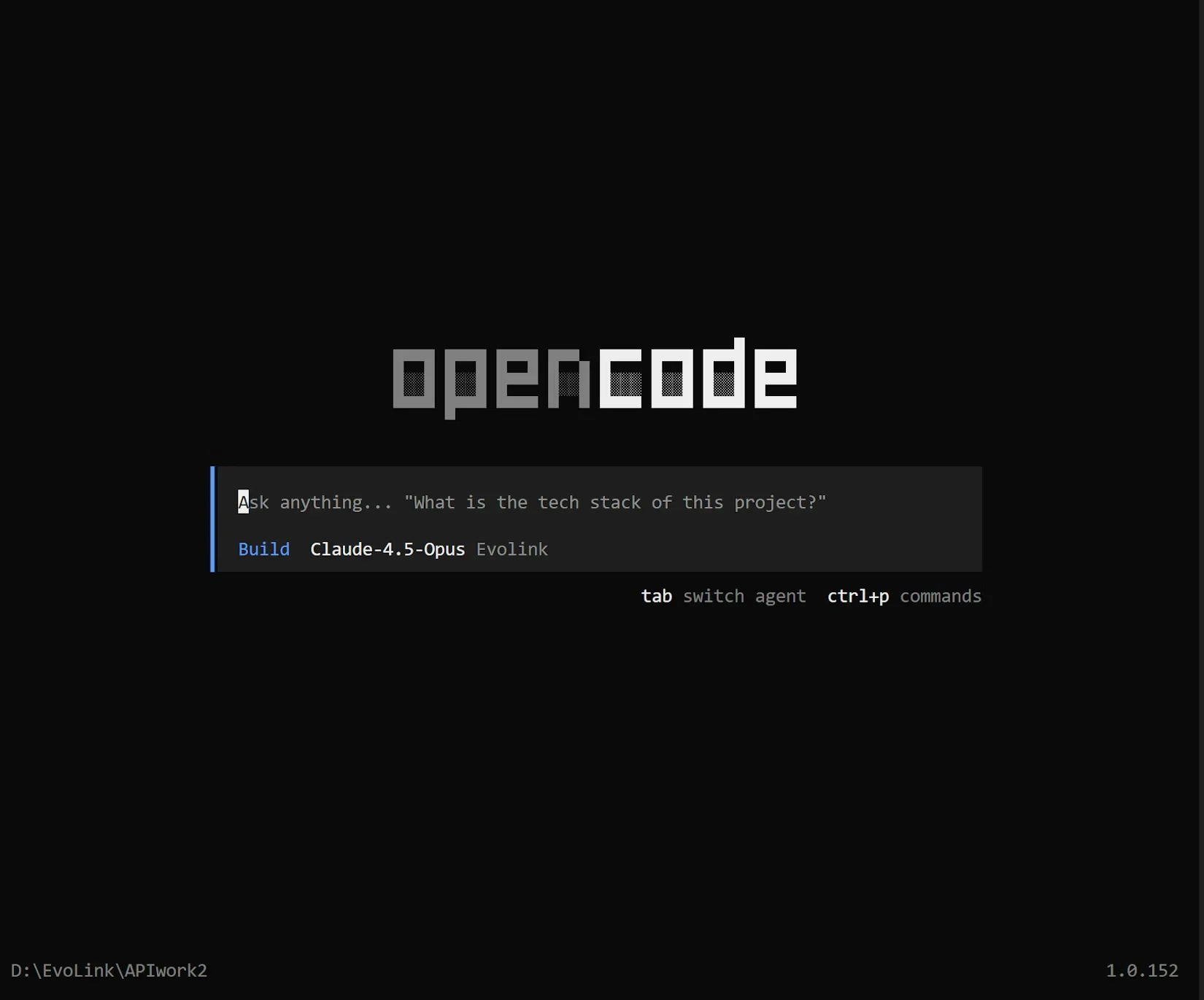

什么是 OpenCode?

OpenCode 是一个基于 Go 的开源命令行编程工具 (CLI),已经席卷了开发者社区,积累了超过 45,000 个 GitHub 星标。与标准的自动完成扩展不同,OpenCode 作为一个自主代理运行。它具有现代终端用户界面 (TUI),允许您:

-

使用自然语言与您的代码库聊天。

-

自主执行终端命令(经许可)。

-

跨项目结构编辑文件。

-

通过直接从输出中读取堆栈跟踪来调试错误。

它的真正力量在于其与提供商无关的设计。OpenCode 不强制您使用特定模型;它充当您选择插入其中的任何智能的容器。

什么是 EvoLink?

EvoLink 是为这种设置提供动力的基础设施层。它是一个智能 API 网关,将 40 多个主流 AI 模型聚合到一个单一接口中。

-

统一访问: 一个 API 密钥让您可以访问 OpenAI、Anthropic、Google、阿里巴巴和字节跳动的模型。

-

成本效益: 通过 智能路由,EvoLink 会自动将请求路由到特定模型的最具成本效益的提供商,与直接使用提供商相比,可节省 20-70%。

-

可靠性: 凭借异步任务架构和自动故障转移,EvoLink 保证 99.9% 的正常运行时间,确保您的编码代理在关键调试会话期间永远不会“挂起”。

第二部分:为什么要将 OpenCode 与 EvoLink 集成?

OpenCode 和 EvoLink 的集成代表了软件开发的“摩天大楼原则”——在坚实的基础上建立以达到新的高度。

-

模型敏捷性: 您可以从使用 Claude 4.5 Opus 编写复杂类切换到 Gemini 3 Pro 分析 500 页文档 PDF,而无需更改配置或 API 密钥。

-

零代码迁移: EvoLink 与 OpenAI API 格式完全兼容。这意味着 OpenCode“认为”它正在与标准提供商对话,而 EvoLink 在后台处理复杂的路由。

-

高密度信息流: 通过连接 OpenCode 读取本地文件的能力与 EvoLink 对高上下文模型的访问,您可以将整个存储库输入上下文窗口进行分析。

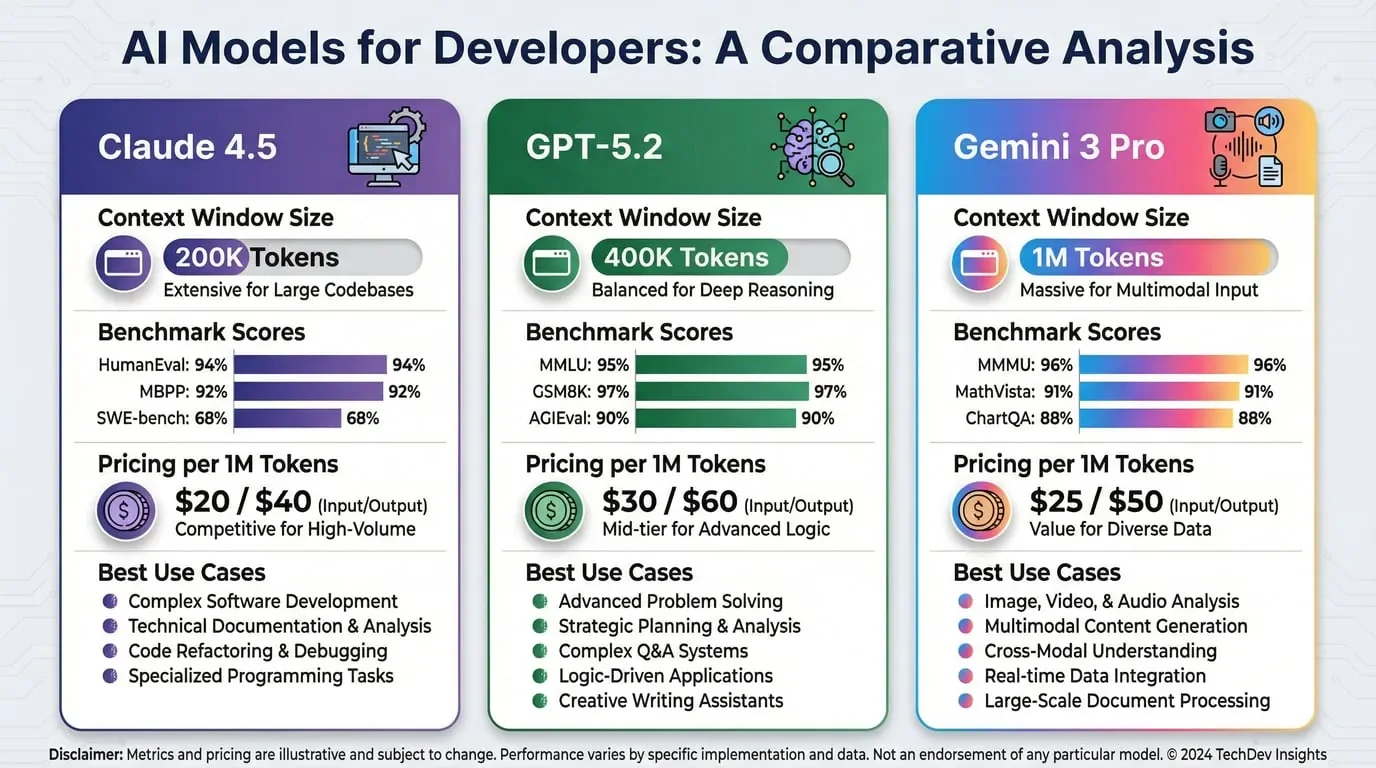

第三部分:了解三个强大的模型(2026 版)

在配置集成之前,了解您正在集成什么至关重要。截至 2026 年初,三个模型主导着这一领域。通过 EvoLink,您可以访问所有这三个模型。

1. Claude 4.5 (Sonnet & Opus)

-

编码架构师

-

最适合: 编写干净、可维护的代码,重构和架构规划。

-

统计数据: Claude 4.5 Opus 在 SWE-bench Verified 排行榜上以 80.9% 的分数占据榜首,这意味着它比任何其他模型都能更好地解决现实世界的 GitHub 问题。

-

为什么在 OpenCode 中使用它: 它产生最像“人类”的代码结构,并且不太容易产生不存在的库的幻觉。它擅长遵循复杂的多步指令。

2. GPT-5.2 - 推理引擎

-

最适合: 复杂逻辑、数学算法和“思考”晦涩的错误。

-

统计数据: GPT-5.2 在 AIME 2025(数学)基准测试中获得完美的 100%,在 ARC-AGI-2 上获得 52.9%,在抽象推理方面显着优于竞争对手。

-

为什么在 OpenCode 中使用它: 当您陷入无法解释的逻辑错误,或需要生成复杂的正则表达式或 SQL 查询时,GPT-5.2 是更好的选择。

3. Gemini 3 Pro - 上下文与多模态之王

-

最适合: 分析大量代码库,阅读文档图像和高速迭代。

-

统计数据: 具有巨大的 100 万 Token 上下文窗口和行业领先的速度(约 180 token/秒)。

-

为什么在 OpenCode 中使用它: 当您需要将整个项目目录输入提示以检查全局一致性时,请使用 Gemini 3 Pro。对于大批量任务,它也是最具成本效益的选择。 | 特性 | Claude 4.5 Opus | GPT-5.2 | Gemini 3 Pro | | --- | --- | --- | --- | | 主要优势 | 代码质量与安全 | 逻辑与推理 | 上下文与速度 | | 上下文窗口 | 200k Token | 400k Token | 100 万 Token | | SWE-bench 分数 | 80.9% (领先) | 80.0% | 76.2% |

| 最适合 | 重构,新功能 | 疑难调试,数学 | 文档,大型仓库 |

第四部分:分步集成指南

本指南假设您在类 Unix 环境(macOS/Linux)或 Windows 的 WSL 中工作。

先决条件

-

终端仿真器: iTerm2 (macOS),Windows Terminal,或 Hyper。

-

EvoLink 帐户: evolink.ai 上的有效帐户。

-

Git: 已安装在您的机器上。

第 1 步:安装 OpenCode

```bash

```bash

```bash

### 第 2 步:获取您的 EvoLink API 密钥

1. 登录到您的 [EvoLink 仪表板](https://evolink.ai/)。

2. 导航到 **API Keys** 部分。

3. 点击 **Create New Key**。

4. 复制密钥字符串(以 `sk-evo...` 开头)。**不要共享此密钥。**

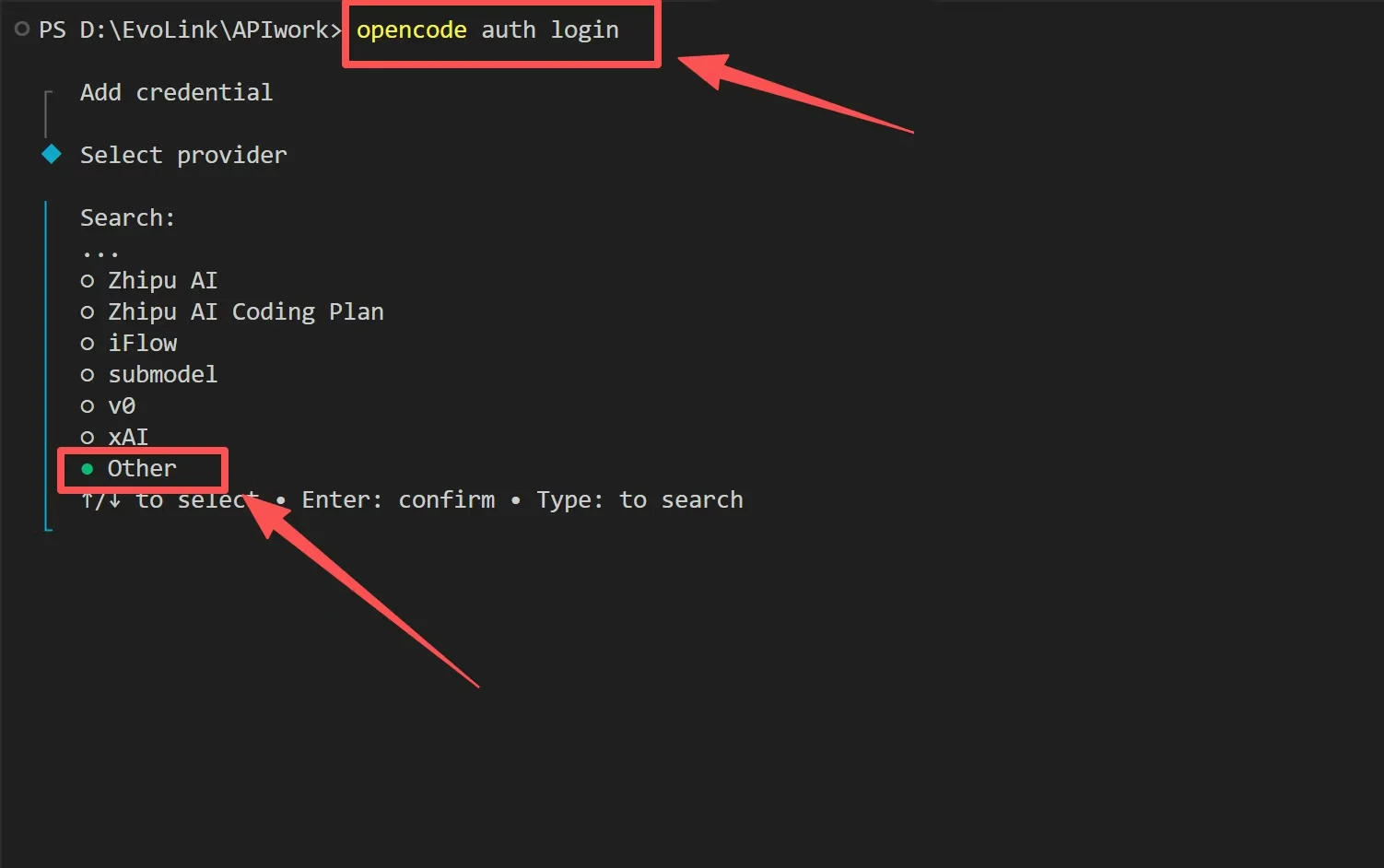

### 第 2.5 步:初始化 OpenCode 提供商

在配置 JSON 文件之前,您需要在 OpenCode 的凭据管理器中将 EvoLink 注册为自定义提供商。这是一次性设置,允许 OpenCode 识别 EvoLink 为有效提供商。

```bash

```bash

2. **当 OpenCode 启动时,它会提示您连接提供商。** 在提供商列表中,向下滚动并选择 **other**(您可以通过输入搜索它)。

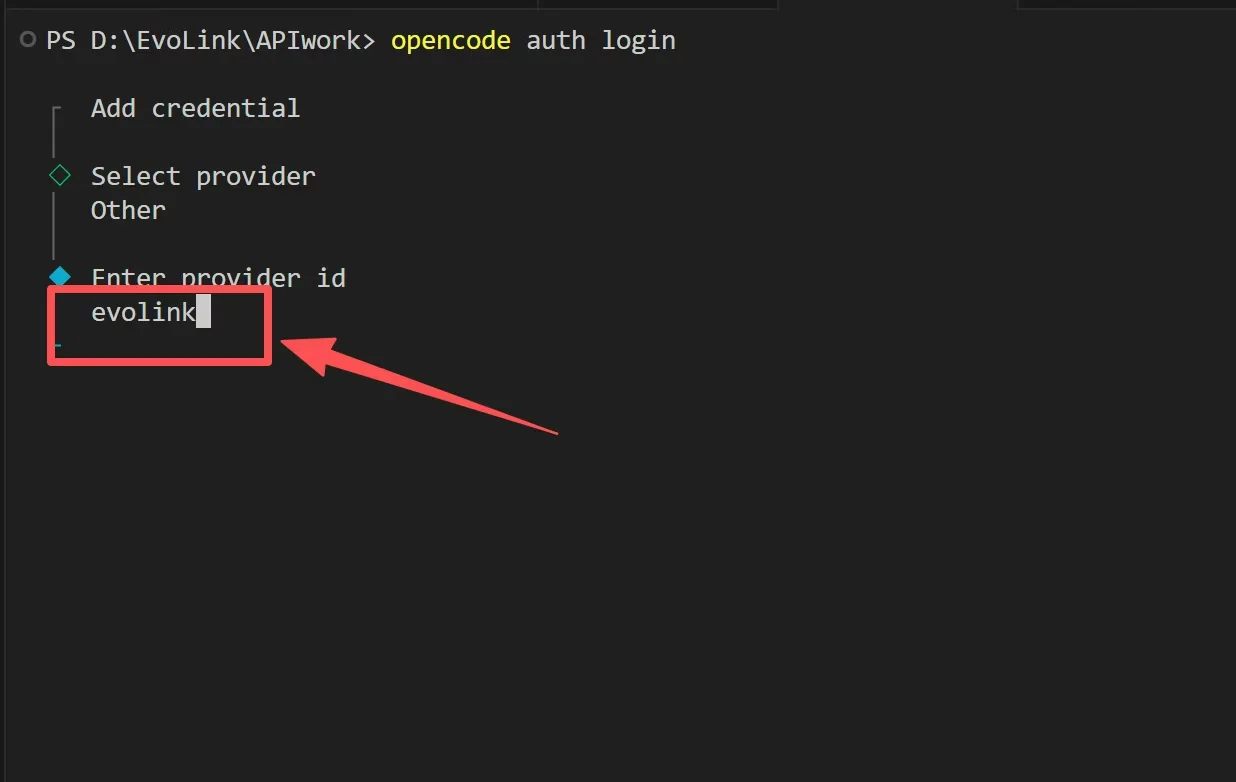

3. **输入提供商 ID:** 出现提示时,输入 `evolink` 作为提供商标识符。这会在 OpenCode 系统中创建一个自定义提供商条目。

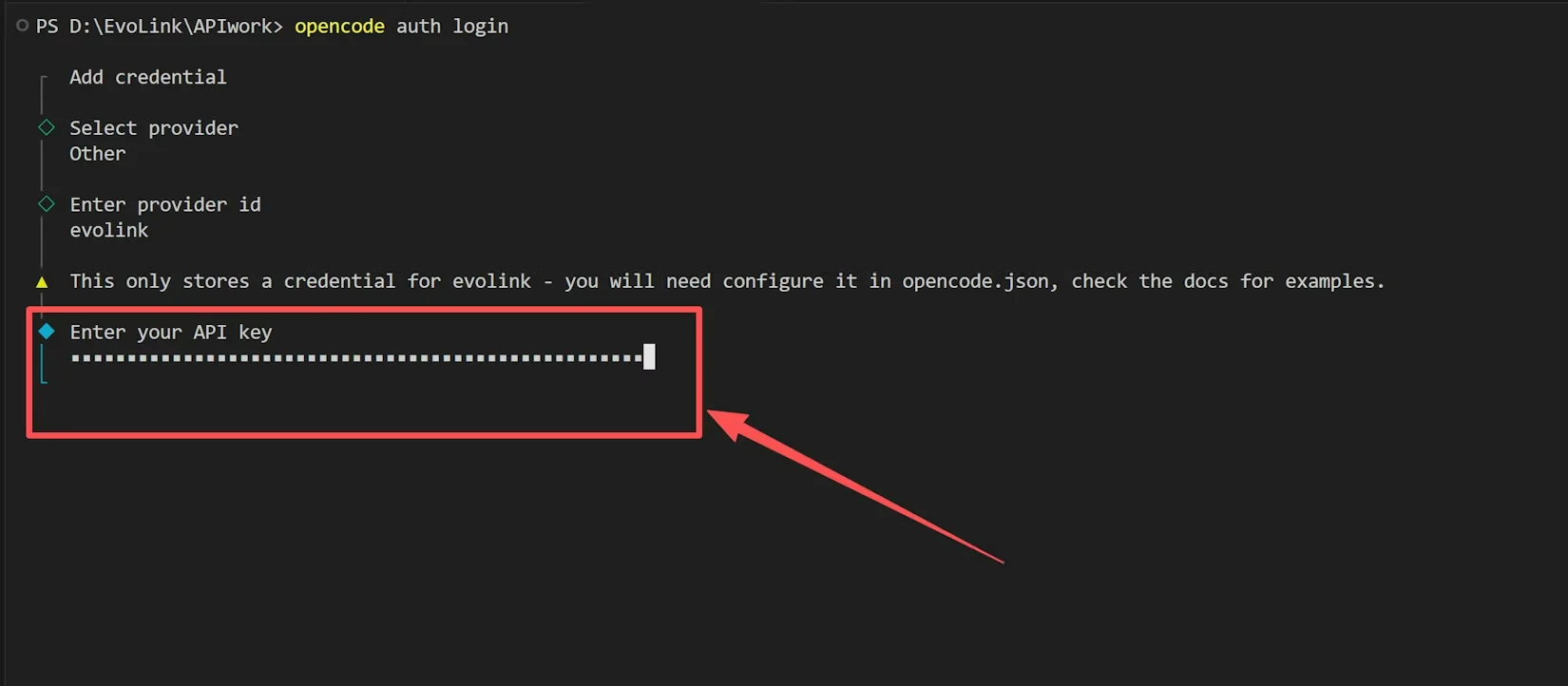

4. **输入 API 密钥:** 您可以在此处输入任何占位符值(例如,`admin` 或 `temp`)。实际的 EvoLink API 密钥将在下一步中通过配置文件引用。

**重要:** 此初始化步骤在 OpenCode 的本地凭据管理器中注册 `evolink`。我们接下来创建的配置文件将提供实际的连接详细信息。

### 第 3 步:配置 OpenCode

1. **定位/创建配置目录:**

- **macOS/Linux:** `~/.config/opencode/`

- **Windows:** `%AppData%\opencode\`

**对于 Windows 用户:** 按 `Win + R`,粘贴 `%AppData%\opencode\`,然后按 Enter 打开目录:

```bash

```bash

mkdir -p ~/.config/opencode

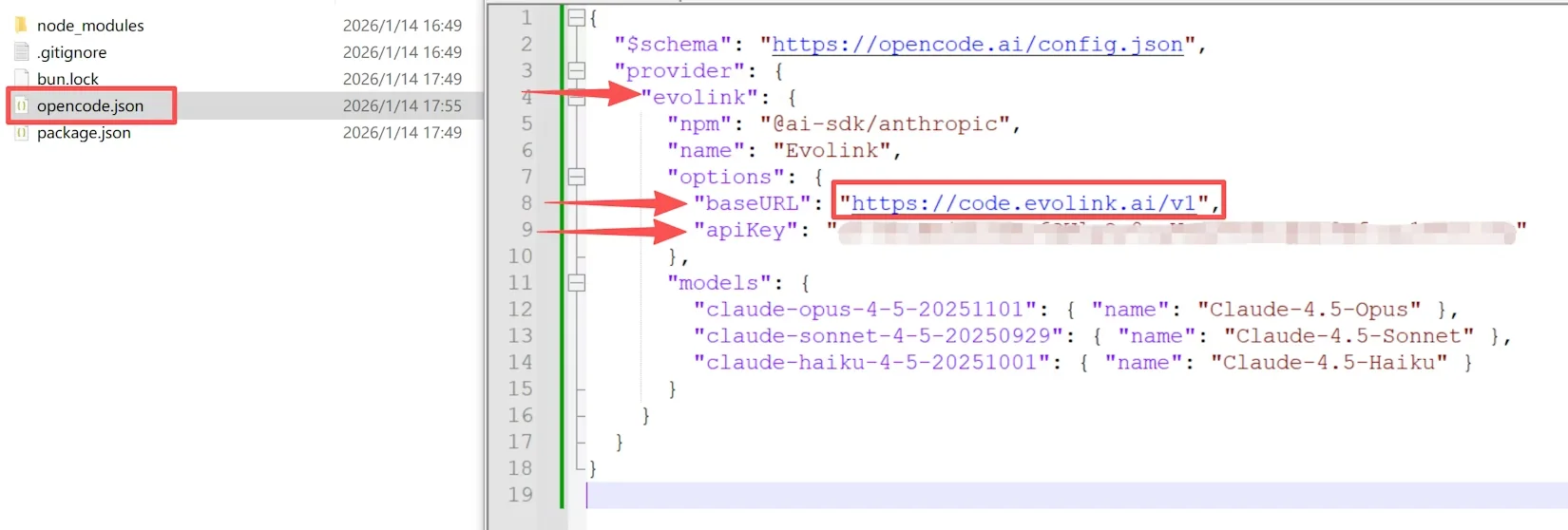

3. **粘贴以下配置:**\

```json

```json

{

"$schema": "https://opencode.ai/config.json",

"provider": {

"evolink": {

"npm": "@ai-sdk/anthropic",

"name": "Evolink",

"options": {

"baseURL": "https://code.evolink.ai/v1",

"apiKey": "your-evolink-api-key"

},

"models": {

"claude-opus-4-5-20251101": {

"name": "Claude-4.5-Opus"

},

"claude-sonnet-4-5-20250929": {

"name": "Claude-4.5-Sonnet"

},

"claude-haiku-4-5-20251001": {

"name": "Claude-4.5-Haiku"

}

}

}

}

**技术说明:** 即使我们使用的是 Claude 和 Gemini 模型,我们在 JSON 中将 `provider` 设置为 `"openai"`。这是因为 EvoLink 无缝地将 OpenAI API 格式转换为 Anthropic 和 Google 的原生格式。这个“技巧”允许 OpenCode 使用标准协议与非 GPT 模型通信。

### 第 4 步:验证连接性

```bash

```bash

在输入框中,输入:

> "Hello, which model are you and who is your provider?"

如果配置正确,响应应确认您定义的模型(例如,“我是 GPT-5.2...”)。

---

## 第五部分:高级配置与模型切换

进入 OpenCode 后,您不会被锁定在一个单一模型中。您可以根据手头的任务动态切换模型。

### 通过 CLI 切换模型

```bash

```bash

# 用于快速逻辑检查

opencode --model gpt-5.2

# 用于繁重的编码会话

opencode --model claude-3-5-sonnet-20240620

通过 TUI 切换模型

在 OpenCode 界面内,您可以使用

/models 命令查看可用配置。

-

输入

/models并按 Enter。 -

从您的

opencode.json列表中选择模型 ID。 -

按 Enter 立即切换上下文。

第六部分:高密度开发的最佳实践

为了真正利用这种集成的“摩天大楼”潜力,请遵循以下最佳实践:

1. 上下文策略

-

使用 Gemini 3 Pro 时: 随意运行像

/add src/这样的命令来添加整个源文件夹。Gemini 的 1M 上下文窗口可以处理负载,使其能够了解您项目的完整依赖关系图。 -

使用 GPT-5.2 时: 更具选择性。仅添加相关文件 (

/add src/utils/helper.ts) 以确保推理引擎严格专注于手头的逻辑,不受干扰。

2. 智能路由用于成本控制

EvoLink 的 智能路由 默认处于活动状态。但是,您可以通过对简单任务使用模型的“Turbo”或“Flash”版本来进一步优化。

- 在您的

opencode.json中配置gpt-4o-mini或gemini-3-flash条目,用于编写简单的单元测试或注释。这些模型的成本仅为前沿模型的一小部分,但足以胜任基本任务。

3. 安全第一

切勿将您的

opencode.json 文件提交到公共存储库。将 .config/opencode/ 添加到您的全局 .gitignore 文件中。echo ".config/opencode/" >> ~/.gitignore_global

git config --global core.excludesfile ~/.gitignore_global第七部分:常见问题故障排除

问:我收到 401 Unauthorized Error。

- 修复: 检查您的 EvoLink API 密钥。确保您复制了完整的字符串

sk-evo...。此外,验证您的 EvoLink 帐户中有正的信用余额。

问:OpenCode 说 "Model not found"。

- 修复: 确保 JSON 中的

model名称与 EvoLink 支持的模型 ID 完全匹配(例如,gpt-4o,claude-3-opus-20240229)。检查 EvoLink 的模型列表以获取确切的 ID 字符串。

问:响应流式传输非常慢。

- 修复: 虽然 EvoLink 很快,但网络延迟会有所不同。检查您是否为一个简单的查询使用了非常大的模型(如 Opus)。切换到

gpt-5.2或gemini-3-flash以获得更快的交互。

结论

通过将 OpenCode 与 EvoLink 集成,您已经构建了一个符合最高效率和能力标准的开发环境。您不再受限于单一 AI 提供商的限制。相反,您拥有一个指挥中心,通过单一、具有成本效益的管道编排世界上最聪明的模型——用于架构的 Claude,用于推理的 GPT,以及用于上下文的 Gemini。

准备好升级您的终端了吗?

-

今天就开始用未来编码。