2025 年 12 月 GPT-5.2 的到来标志着 AI 发展的一个重大范式转变。我们正在超越仅仅生成看似合理文本的模型,转向能够进行可靠推理的系统。对于工程师和 CTO 来说,这不仅仅是一个增量升级;这是我们构建和部署关键任务应用程序方式的根本性变化。GPT-5.2 不仅更“聪明”——它还针对定义现代企业软件的高并发、复杂工作流进行了优化。

关键要点

- 高级推理: GPT-5.2 在“系统 2”逻辑推理方面表现出显著的飞跃,减少了幻觉,并能够在单次通过中解决更复杂的问题。

- 生产就绪?: 虽然非常强大,但该模型在智能、延迟和成本之间引入了关键的权衡。它并不是 GPT-4o 的通用替代品。

- Agent 能力: 极大改进的函数调用和 JSON 模式依从性使其成为构建可靠的自主 Agent 和结构化数据提取管道的优选。

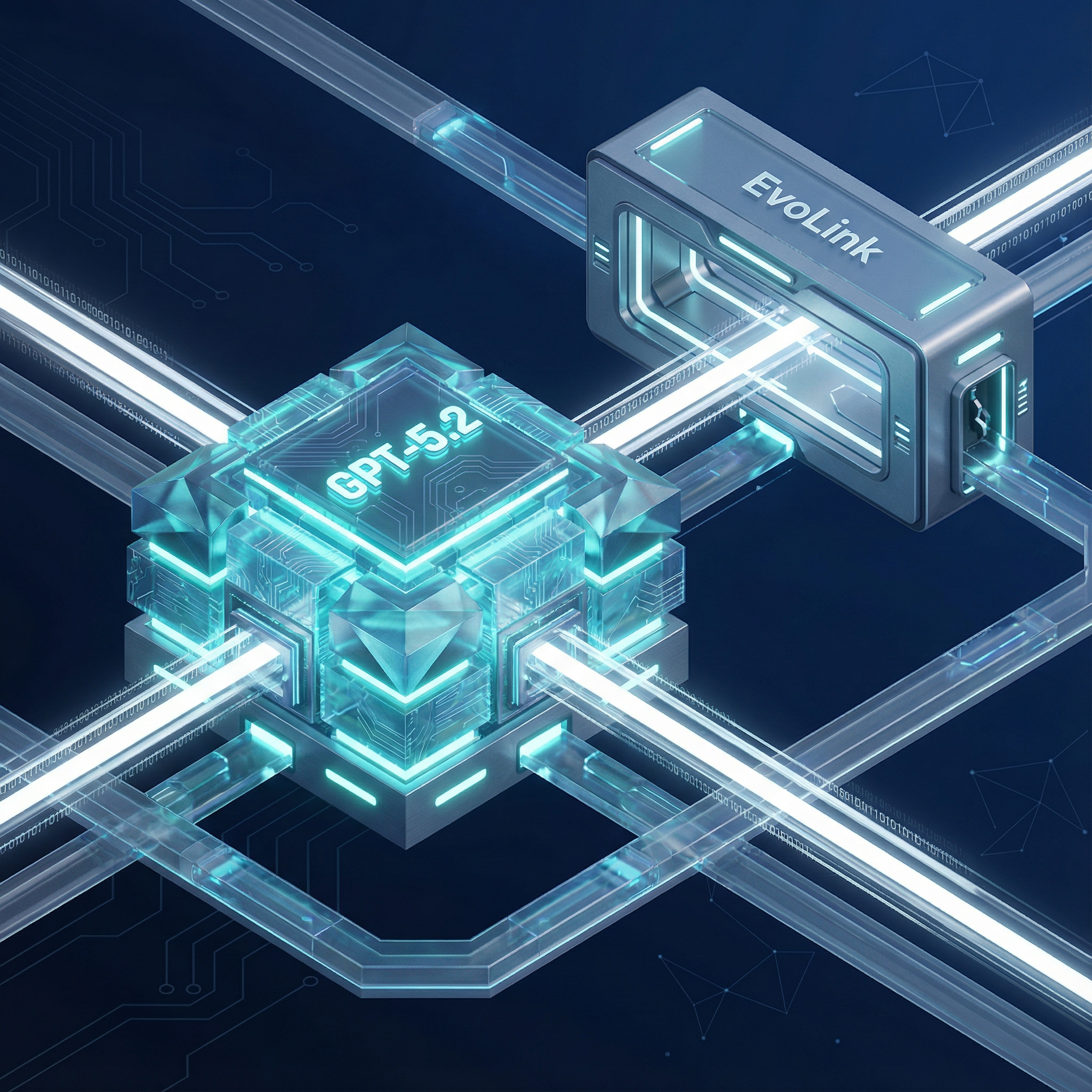

- 集成与成本: 直接访问受限且昂贵。像 EvoLink 这样的统一 API 层对于管理成本、通过模型回退确保可靠性以及简化集成至关重要。

GPT-5.2 是什么:架构概览

GPT-5.2 代表了一次重大的架构演进。虽然 OpenAI 对具体的实现细节守口如瓶,但性能的提升指向了关键的进步:

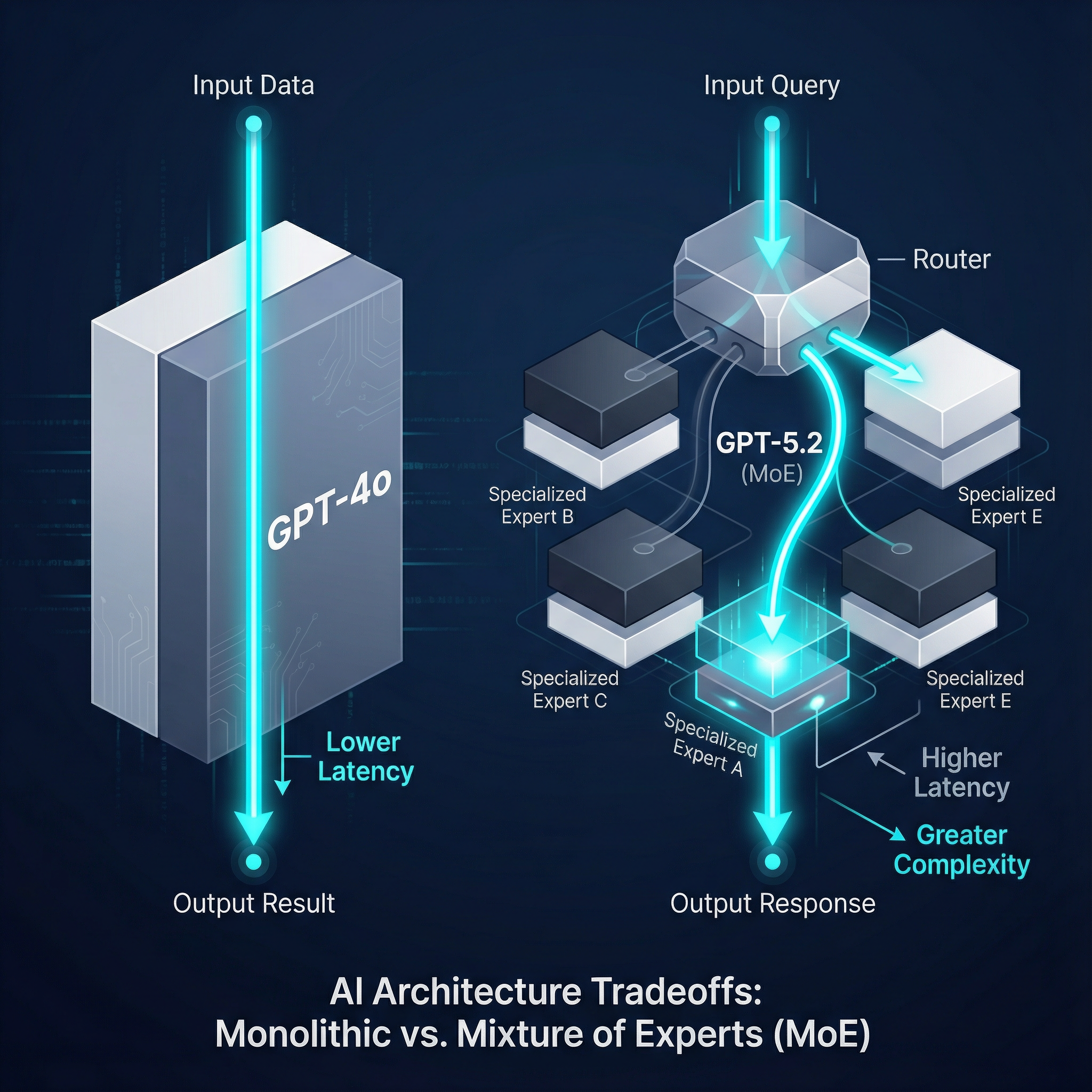

- 架构: 被广泛认为是一个复杂的混合专家 (Mixture of Experts, MoE) 模型。与它的前辈不同,它可能将查询路由到专门的子网络,从而提高特定领域任务(例如,编码 vs. 创意写作)的效率和能力。

- 上下文窗口: 扩展到强大的 400K token,能够对大型文档、代码库或复杂的对话历史进行更深入的分析。

- 多模态: GPT-5.2 是原生多模态的,能够以更统一的理解处理文本、图像和音频输入。这使得它能够即时解释复杂的数据可视化、UI 和音频提示,而无需链接单独的模型。

- 推理 Token: 推测指向一种新机制,可能是“推理 token”,它允许模型在生成最终答案之前执行更明确的“系统 2”思考,从而提高其在复杂逻辑和数学问题上的表现。

为什么 GPT-5.2 对生产系统至关重要

对于那些构建现实世界产品的人来说,新模型的价值在于可靠性和性能,而不仅仅是基准测试分数。

1. 可靠性

最显著的进步是幻觉率的急剧下降。对于法律、医疗或金融分析中的关键任务应用程序,这种增强的可靠性将指针从“实验性”移动到了“可信赖”。

2. 推理深度

GPT-4 通常需要复杂的提示链 (prompt chains) 来解构问题,而 GPT-5.2 可以在单次推理中处理多步逻辑。这简化了应用程序架构并减少了故障点。

3. Agent 能力

根据早期开发者的反馈,函数调用和 JSON 模式现在“坚如磐石”。模型可靠地遵守结构化数据格式的能力使其成为驱动自主 Agent 和可预测的 API 驱动工作流的新黄金标准。

权衡

这种智能的飞跃是有代价的。GPT-5.2 比其前辈具有更高的延迟和更高的每 token 价格。核心工程挑战不再是“模型够聪明吗?”,而是“对于这个特定用例,增加的智能是否值得这额外的延迟和成本?”

为您的生产环境解锁 GPT-5.2

厌倦了等待名单和不可预测的成本? 获得对 GPT-5.2 API 的即时、可扩展访问,且没有摩擦。EvoLink 提供具有批发批量定价和企业级可靠性的统一 API。

核心能力与优势

GPT-5.2 的优势在需要深厚专业知识和精度的任务中最为明显。

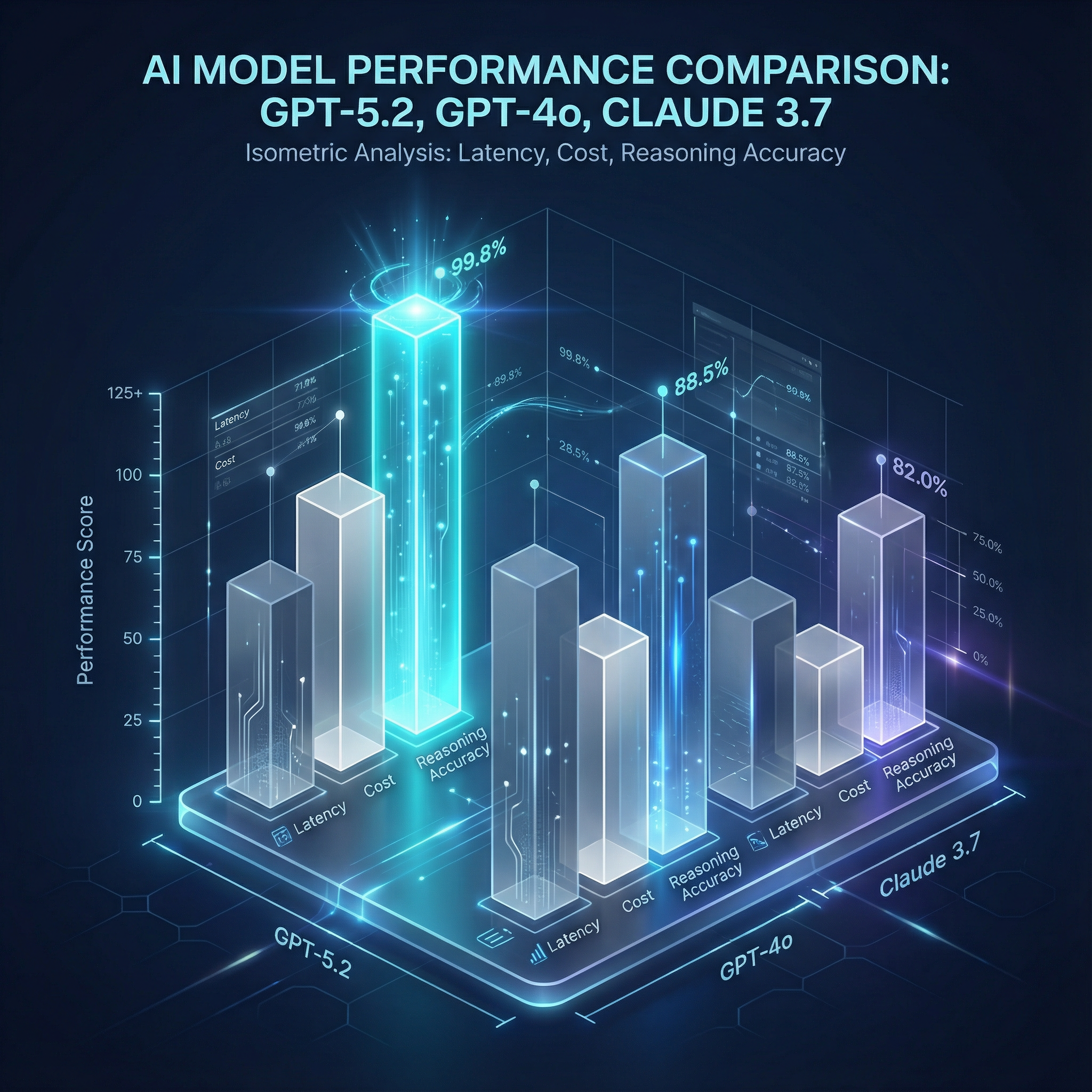

- 高级推理: 在 MATH 和 GSM8K 等关键基准测试中优于 GPT-4o 和 Claude 3.7,展示了其解决研究生级数学和逻辑问题的能力。

- 编码能力: 在 HumanEval 和 SWE-bench 上显示出显著改进。它不仅可以生成代码,还可以理解和调试复杂的代码库,使其成为强大的结对程序员。

- 多模态流畅性: 可以即时分析金融图表,向自动化脚本解释用户界面截图,或转录和总结音频——所有这些都通过单个 API 调用完成。

- 长上下文召回: 在“大海捞针”测试中表现出色,能够准确回忆起埋藏在其 400K token 上下文窗口深处的特定事实。这对于分析密集研究论文或法律文档的 RAG 系统至关重要。

基准测试与权衡(“真实”数字)

虽然基准测试说明了一部分问题,但生产指标更为重要。这是基于早期数据和社区报告的务实比较。

| 模型 | 输入成本 ($/1M tokens) | 输出成本 ($/1M tokens) | 上下文窗口 |

|---|---|---|---|

| GPT-5.2 | $1.75 | $14.00 | 400K |

| GPT-4o | $1.25 | $10.00 | 128K |

| Claude 3.7 | $1.50 | $12.00 | 200K |

| Llama 4 (Open) | $0.50 | $4.00 | 100K |

关键指标

- 延迟 (TTFT): GPT-5.2 的首字延迟 (Time To First Token) 明显高于 GPT-4o。对于实时对话聊天机器人,这可能会降低用户体验。它更适合几秒钟处理时间可以接受的异步任务。

- 每 Token 成本: 输入 $1.75 和输出 $14.00(每百万 token),这是高端选项。在 GPT-5.2 上更便宜的复杂任务(由于重试次数减少)按绝对值计算可能仍比在 GPT-4o 上使用链式提示的方法成本更高。

- 吞吐量 (TPS): 官方提供商通常施加严格的速率限制(“第 5 层”访问),使其难以扩展。生产系统需要一个能够处理高每秒 token 数 (TPS) 并管理并发的解决方案,这是使用像 EvoLink 这样的 API 网关的核心优势。

开发者情绪与社区见解

工程社区的反应务实且富有洞察力,透过炒作看到了本质。

赞扬

“终于以更少的幻觉解决了复杂的逻辑任务。我们用一次 GPT-5.2 调用替换了 5 步提示链。”

“JSON 模式对于 API 响应来说坚如磐石。我们看到了 99.9% 的合规性,这在以前的模型中是闻所未闻的。”

抱怨

“更聪明的输出换来的是更高的延迟。这对于我们的交互式功能来说很难卖座。”

“迁移很顺利,但每 token 的成本加起来很快。你必须非常谨慎地决定将哪些任务卸载给它。”

开发者论坛上的一个反复出现的主题是“成本 vs. 能力”的计算。一位 Reddit 用户指出:

“EvoLink 的回退功能在高峰负载期间拯救了我们。我们将简单的查询路由到 4o,只使用 5.2 处理繁重的工作。这是让经济账算得通的唯一方法。”

定价与成本效率

大规模运行 GPT-5.2 是一笔重大的财务承诺。通过官方提供商的“第 5 层”访问问题意味着许多企业由于严格的速率限制和等待名单而碰壁。此外,跨多个模型和提供商管理计费会产生不必要的运营开销。

这就是 API 基础设施层变得至关重要的地方。EvoLink 直接解决了这些挑战:

- 批发批量定价: 通过聚合需求,EvoLink 提供 GPT-5.2 等模型的批量折扣费率,这是个体公司通常无法获得的。

- 统一计费: 将 GPT-5.2、GPT-4o、Claude 和其他模型的支出整合到一张发票中。这简化了整个 AI 栈的成本跟踪和预算管理。

- 智能路由与回退: 不要为简单的任务支付高价。使用 EvoLink 动态地将请求路由到能够处理该工作的最具成本效益的模型,并具有自动回退功能以确保正常运行时间。

如何通过 API 集成 GPT-5.2

base_url 指向 EvoLink 端点。这一简单的更改即可解锁与模型无关的路由、回退和成本优化,而无需更改您的核心应用程序逻辑。这是一个简洁的 Python 代码片段,演示了通过 EvoLink API 网关对 GPT-5.2 进行流式调用。

import requests

url = "https://api.evolink.ai/v1/chat/completions"

payload = {

"model": "gpt-5.2",

"messages": [

{

"role": "user",

"content": "Please introduce yourself"

}

],

"temperature": 1,

"stream": False,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0

}

headers = {

"Authorization": "Bearer <token>",

"Content-Type": "application/json"

}

response = requests.post(url, json=payload, headers=headers)

print(response.text)迁移清单:您的应用准备好迎接 GPT-5.2 了吗?

- 识别高价值用例: 查明深度推理和低幻觉至关重要的任务(例如,法律合同分析、复杂代码生成)。

- 评估延迟容忍度: 您的用户体验能否容忍稍长的响应时间以换取更聪明的答案?

- 实施路由器/网关: 使用像 EvoLink 这样的服务来避免供应商锁定,并启用 GPT-5.2 与 GPT-4o 等更经济模型之间的动态切换。

- 重写关键提示: 虽然许多提示开箱即用,但微调您最重要的系统提示以利用 GPT-5.2 的高级推理能力。

- 密切监控成本: 设置仪表板以跟踪 token 消耗。如果用于每个查询,GPT-5.2 的成本可能会迅速升级。

用例与决策指南

选择正确的模型是一个关键的架构决策。

何时使用 GPT-5.2

- 自主 Agent: 构建需要以高可靠性执行多步任务并每次都正确使用工具(函数调用)的 Agent 时。

- 复杂 RAG: 对于必须高度保真地从多个密集的技术文档中综合信息的问答系统。

- 高级编码助手: 对于需要理解整个代码库、生成复杂逻辑并识别细微错误的工具。

- 法律与医疗分析: 在精度不可协商且幻觉不可接受的领域。

何时停留在 GPT-4o / Mini

- 高容量分类器: 对于简单的文本分类、情感分析或数据提取,速度和低成本是首要任务。

- 简单聊天机器人: 当目标是对话流畅和快速响应而不是深度解决问题时。

- 延迟敏感流: 对于像实时转录或交互式搜索建议这样每一毫秒都很重要的实时应用程序。

结论:战略升级路径

GPT-5.2 不仅仅是一个强大的新模型;它是用于高风险推理任务的专用工具。由于成本和延迟,将所有 AI 工作流全面升级到 GPT-5.2 不仅不切实际——这是糟糕的工程设计。

生产 AI 的未来不是寻找唯一的“最佳”模型,而是构建一个灵活、智能且具有成本意识的系统。

常见问题 (FAQ)

1. GPT-5.2 的定价与 GPT-4o 相比如何?

GPT-5.2 的每 token 价格明显更高。平均而言,您可以预期输入成本比 GPT-4o 高约 40%,输出成本高约 40%。这使得成本管理策略变得至关重要。

2. GPT-5.2 的提示工程 (prompt engineering) 有什么不同吗?

虽然许多提示可以按原样工作,但您可能没有利用其全部力量。提示可以简化,减少对“思维链” (chain-of-thought) 或少样本 (few-shot) 示例的需求,因为模型内在的推理能力更强。

3. GPT-5.2 的 JSON 模式有多可靠?

极其可靠。开发者的反馈表明这是该模型最突出的功能之一,使其非常适合结构化数据提取和构建可靠的 Agent 工作流。

4. 使用 EvoLink 访问 GPT-5.2 的主要好处是什么?

EvoLink 提供了一个统一的 API 来访问 GPT-5.2 以及其他模型,综合计费,批量定价折扣,优化成本的智能路由,以及提高可靠性的回退功能。

5. GPT-5.2 的上下文窗口与 Claude 3.7 相比如何?

GPT-5.2 具有 400K token 的上下文窗口,是 Claude 3.7 的 200K 上下文窗口的两倍。这使其能够在单次通过中处理和分析更大量的卷信息。